Scission de ce sujet pour mieux s’y retrouver :

Je ne connais pas cette personne, mais je trouve qu’il y a des informations douteuses, ou abus de langage, juste sur les premières minutes (à partir de la 44ème minute).

Par exemple quand elle dit que la “courbe standard” résulte en une surexposition, je trouve que c’est un abus de langage car en photographie, surexposer revient à appliquer un coefficient multiplicateur à l’ensemble ce qui correspond à une augmentation linéaire (pas une courbe) des valeurs d’exposition. La preuve sur le graphique qu’elle montre, la “courbe standard” rejoint la courbe linéaire en haut à droite, ce qui ne serait pas le cas s’il y avait une réelle surexposition. En d’autres termes, la surexposition impose par la courbe standard ne se fait que sur les tons moyens, et sont effet diminue à mesure qu’on approche des hautes lumières.

Ensuite elle donne une fausse information quand elle parle du nombre de couleurs en comparant les 20000 niveaux de couleur pour la peau à un raw de 14 bits qui donnerait seulement 16384 niveaux de couleur “par couche” (elle aurait du dire 16384 -en réalité de 0 à 16383- niveaux de gris par sensel, ou pixel sensible du capter). A première “il n’y a pas photo” (jeu de mots…), 16384 c’est bien moins que 20000… Mais son énorme raccourci c’est que quand l’image raw est dématricée, les infos des sensels sont combinées de sorte qu’un pixel décodé en RGB aura environ 16384 x 16384 x 16384 = 4 398 046 511 104… Plus de 4000 milliards de valeurs possibles. Je crois que sa comparaison ne tient pas la route. En fait, comparer le nombre de bits d’un fichier raw à un nombre de niveaux de couleurs n’est pas vraiment correct (https://www.dpreview.com/articles/4653441881/bit-depth-is-about-dynamic-range-not-the-number-of-colors-you-get-to-capture)

Tout à fait d’accord avec ton calcul. Mais il me semble que les nuances différentes de peau sont approximativement de 20000 (dixit Aurélien).

Autre approximation, c’est du 50 mm qui n’aurait besoin que de 2 lentilles mais le plus simple 50 mm à 4 lentilles en 2 groupe est la formule Tessar et la formule Planar en a 6, ce qui lui permet une plus grande ouverture.

Après cette vidéo est très intéressante notamment au niveau du dématriçage linéaire et aussi sur quelques contre-vérités qui pullulent un peu partout !

Merci pour ces rectifications sur les approximations et raccourcis qui méritent d’être corrigées lorsqu’on se veut pointu sur la technique.

L’on pourrait y ajouter celle de l’étymologie du mot “photographie” qui n’est pas “écrire avec la lumière” (un art) mais qui provient d’un procédé (une technique) de reproduction d’image (*)

Cela n’en reste pas moins pertinent de rappeler l’imbrication de la technique avec la démarche créatrice (l’art est un artifice au service d’une expression) pour laquelle la première reste un moyen ce qui suppose d’apprendre à suffisamment la connaître et la maîtriser pour ne pas la subir.

(*) Raccourcis corrigé par l’auteur lui-même une autre conférence

Bien entendu la conférence était intéressante, on sent la conférencière à l’aise dans la mise en œuvre de son art, j’ai particulièrement apprécié le chapitre sur le noir et blanc. C’est juste sur les aspects technologiques qu’elle manque de précision.

J’ai aussi l’impression qu’elle dit à tout le monde d’utiliser la méthode linéaire pour le développement des images raw, mais sauf si j’ai raté quelque chose, elle n’explique pas comment faire.

L’on avait abordé le sujet du développement en courbe linéaire sur ce fil (qui fait encor référence à une vidéo de Nath-Sakura,)

Avec un résumé du principe de développement dans ton intervention

J’avais moi-même oublié mon intervention ![]()

En tous cas j’ai fait un essai avec un profil gamma 1.0 de Elle Stone, et le résultat est strictement identique à si j’utilise “aucun profil” comme profil d’entrée dans le module “Gestion des couleurs”.

Personnellement, je fais confiance aux développeurs de RT et ART, en particulier Alberto qui, je pense, a fait en sorte que les bons modules soient traitent l’image dans un espace linéaire quand il faut. Je pense que le “développement en linéaire” était valable à une époque où le développement des raw se faisait surtout avec Adobe Camera Raw… Époque révolue depuis quelques années déjà. Mais je peux me tromper.

J’ai fait un test en téléchargeant un profil d’entrée .dcp linéaire pour un de mes boîtiers, mais franchement je ne trouve pas le résultat si merveilleux pour ce qui est de la récupération des hautes lumières. Peut-être parce-que justement ART fait bien le travail là où il faut en linéaire sous le capot.

Par contre ça m’a donné l’idée de regarder parmi les scripts CTL ce qui pouvait exister, et j’ai trouvé que le script “Transformation de sortie ART” permettait de bien récupérer les hautes lumières.

Bonsoir - Je viens de compléter mon installation d’ART avec les scripts (*) que je n’avais pas encore explorés mais l’utilisation de celui que tu proposes ne m’a pas convaincu - et comme tu l’indiquais dans cet autre fil leur utilisation nécessite de bonnes connaissance.

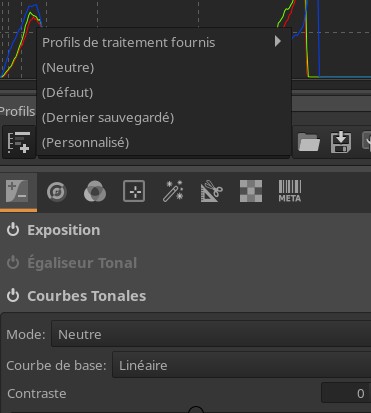

En fait de “courbe linéaire” je me contentais de choisir un profil neutre plutôt qu’une courbe basée sur l’aperçu.

(*) Rappel de la discussion sur l’utilisation Qu'est-ce que CTL? - #16 par guynux

La courbe linéaire dans le module de Courbe tonale, c’est autre chose que le profil d’entrée linéaire en effet.

Quant au CTL Transformation de sortie, il ne fait pas tout à lui tout seul, et il interagit fortement avec les autre modules de tonalité. J’ai juste fait un essai rapide avec une image de coucher de soleil avec un ciel proche d être cramé et un premier plan dans l’ombre en contre jour, et j’ai pu obtenir une récupération plus efficace des hautes lumières en combinant Transformation de sortie ART et d’autre modules. Ce n’est pas la manière théoriquement appropriée de le faire, mais le résultat m’a beaucoup plu. Et c’est là l’essentiel !

Pour illustrer la méthode - d’une “surexposition” à 1,33 diaf + développement à courbe linéaire (neutre) du raw : à partir de 44ème minutes mais le début de la conférence de Nath Sakura est tout aussi intéressant :

Me semble que Camera Raw est toujours utilisé pour dématricer et est passé aussi en développement linéaire (notamment avec PhotoShop mais aussi à l’ouverture de LR) !

J’avais écrit : Quand LightRoom suit darktable

J’espère, en tant que développeur de Rawtherapee, apporter quelques éclaircissements sur ces(s) sujet(s) complexes et souvent polémiques.

Je ne parlerais (sommairement) que du traitement Raw et débuterais par tout ce qui est commun à ART et RT.

Il faut d’abord savoir que en interne, le processus (pipe-line) est divisé en 4 sous-parties, imaginées par Gabor Horvatz il y a 20 ans, avec un code qui à l’air dupliqué, mais où les dimensions de l’image (ou d’une partie de l’image) sont traitées séparément

- la partie pour sortie (output) des TIFF / JPG, etc. C’est là qu’on applique un profil de sortie pour que ce TIF/JPG puisse être utilisé ailleurs (Photoshop, Gimp, etc.)

- la partie qui génère les vignettes - celles qui apparaissent dans le “preview” (le catalogue du démarrage)

- la partie - qui est le centre du système - qui pilote la plupart des fonctions internes (dématricage, balance des blancs, exposition, etc.) qui génère l’histogramme et la sortie vers l’écran.

- la partie qui gère ce que vous voyez à l’écran, avec le gros problème du zoom.

Dans RT comme ART l’interface graphique est traitée à part (ce n’est pas le cas dans Darktable). Et il est évident qui faut faire un lien entre le GUI et le pipe-line. Cela se fait via les pp3 ou arp. Le problème n’est pas aussi simple qu’il y paraît, car si vous avez des évolutions de comportement voulues par les développeurs (ou souhaitées par les utilisateurs) , il faut assurer la compatibilité avec les anciennes versions.

Par exemple lorsque Alberto a créé ART, il a rompu la compatibilité avec les pp3 et de ce fait pu facilement “simplifier” (c’est quoi simplifier ?) l’interface en supprimant des fonctions ou des curseurs… Difficile à faire pour Rawtherapee… Je néglige aussi la nécessité ou non de faire des traitements “Batch”, qui eux aussi amènent une complexité supplémentaire. Il est certes très facile de simplifier RT… mais au prix de la compatibilité.

Revenons au pipe-line. Pour éviter des temps de traitement trop longs, seuls sont réexécutés les processus situés derrière celui sur lequel vous intervenez. Donc chaque fonction est notée avec un “event” de plus ou moins haute priorité, mais chaque fonction “passe” ses paramètres à la suivante. Ce n’est pas le cas de Darktable, où on peut changer l’ordre, mais chaque module est “indépendant” - donc sans passage de paramètres.

Dans cet ensemble, le système commence par lire le fichier Raw (il s’aide pour cela de matrices constructeur - souvent fournies par Adobe - qui se trouvent soit dans une bibliothèque Libraw ou Dcraw).

Ensuite débute le traitement propre du Raw, qui est ce qu’on appelle “linéaire”…Par opposition à un traitement qui ne le serait pas - donc par exemple avec un gamma (le gamma n’intervient que en sortie pour piloter le moniteur). Dans RT comme ART tout est linéaire, même si il est évident que toutes les retouches faites, par exemple le dématricage, le traitement récupération des hautes lumières, la balance des blancs, etc. modifient cette linéarité. C’est ici qu’on applique le “Working profile” (qui n’a rien à voir avec un profil ICC) qui est une matrice de conversion - celle qui va fixer les limites du gamut de ce que vous voulez ou non qui soit pris en compte (Prophoto, Adobe, Rec2020… il n’y a pas de vérité la dedans… et aucun gamma n’est appliqué). Ensuite on applique des profils d’entrée ICC ou DCP pour avoir (ce n’est pas toujours le cas) un meilleur rendu des couleurs et /ou “auto match tone curve” qui - en prenant les données du JPG incorporé au Raw va donner le “rendu” typé Nikon, Canon, Sony, etc.

Mais il faut bien pouvoir modifier l’image : traitement HDR, contraste, saturation, etc.

Dans ART comme RT ces traitements sont soit faits en mode RGB ou en mode Lab (qui n’est pas linéaire). Mais dès que vous utilisez une courbe de contraste, une fonction “Log”, etc. Il est évident que ce n’est plus linéaire.

Je profite de ce moment pour expliquer (un peu) certains choix de RT. Alberto a voulu simplifier l’interface et donc supprimé des fonctions qui ont l’air complexes, comme Ciecam ou Wavelets (la version “Local contrast” de ART est une copie ligne par ligne de la partie de Wavelets que j’ai créé il y a 10 ans).

Ces 2 produits ne sont pas des “gadgets”, certes il repoussent au premier abord, mais en général ceux qui y ont gouté ne veulent plus s’en passer.

Je vais un peu expliquer Ciecam, et ceux qui connaissent Darktable vont retrouver (un peu) leurs petits.

Ciecam est divisé en 3 processus :

- Scene conditions (DT appelle cela Scene Reffered, mais n’a pas la même envergure), qui prend en compte les conditions de prise de vue - il peut sembler évident, même si votre appareil “compense” que l’aspect d’une scène le matin, le midi est différente.

- Les traitements proprement dit, là Ciecam fait intervenir 6 variables (au lieu de 3) pour prendre en compte la perception de notre couple œil/cerveau (notion de contraste simultané, etc.)

- Viewing conditions (DT - Display referred), où vous prenez en compte les conditions de projections (TV, projecteur, ambiance de la salle…, etc.)

La partie “Scene conditions” est normalement proche du début du traitement et donc dans une partie assez linéaire.

La partie “Viewing conditions” est normalement à la fin et obligatoirement non linéaire.

Je vais en rester pour ce moment. Mais si vous souhaitez plus d’informations, pas de problèmes.

Jacques

Merci Jacques pour ces précisions. Faudra que je revois un peu ce que tu as fait dans RawTherapee. Je dois dire que j’ai un peu de mal avec l’utilisation des U-Point dans PhotoLab et encore plus avec RawTherapee !

juste une précision, darktable utilise aussi un pipe-line sauf qu’il est modifiable au risque de l’utilisateur !

Pour l’essentiel c’est une question de désapprentissage et d’apprentissage d’un nouveau processus. C’est de l’ergonomie cognitive.

Pour beaucoup de Photographes (je vais avoir 78 ans… donc pas jeune), nous avons débuté avec la photo argentique, le noir et blanc , les agrandisseurs et les masques (souvent très simplifiés, la main par exemple). Donc on a pris l’habitude de travailler en “négatif” avec des masques.

Adobe en créant Photoshop il y a plus de 20 ans a eu l’idée de “reproduire” ce schéma noir et blanc. Et beaucoup de produits ont copié (ART, Darktable, C1, Lightroom évidemment).

Nikon Capture NX2 en 2006 a fait autre chose “Travailler en positif” … on voit ce qu’on retouche, et non en négatif. Bien sûr je n’ai pas le code de Niksoftware, mais j’ai imaginé quelque chose, qui du point de vue de nombreux utilisateurs est plus performant que “l’original”… Ce système permet de faire a peu près tout ce qu’on peut faire avec des masques, mais totalement différemment. Ceux qui n’ont pas connu les masques, trouvent les RT-points considérablement plus simple. Mais tout est affaire de point de vue, d’habitudes…

Merci

Jacques

Je te suis de très près en age, j’ai aussi commencé en argentique et j’ai fait pas mal de travaux de laboratoire donc les solarisations ; contre-typages négatifs-positifs et autres isohélies ! Je me suis habitué aux masques de darktable qui ont largement évolués depuis le début et aussi la possibilité de les avoir dans pratiquement dans tous les modules et aussi de les dupliquer.

Je vais quand même voir ce que deviennent les RT-points !

C’est un peu hors-sujet ici (forum ART, mais comme tu évoques les RT-spot (U-points).

Je ne vais pas décrire les RT-points (quoique vue l’absence de Rawpedia en ligne depuis près de 3 mois…) , mais tu peux pratiquement tout faire avec: dupliquer, ajouter de nouveaux RT-spots… (plus de 100). Bien sûr, les grincheux diront qu’il manque ceci ou cela… Mais on peut dire la même chose pour les masques.

On m’ a demandé d’ajouter des masques - il y en a pas en mode ‘basic’, mais du point de vue du créateur (moi en l’occurrence) dans 99.99% des cas cela ne sert strictement à rien, sinon à compliquer l’interface et troubler l’utilisateur.

Pour simplifier à l’extrême le système fonctionne par différences de couleurs (deltaE) entre la position du Spot et le reste de l’image. La zone d’action est limitée par les limiteurs du Spot. Une transition est appliquée à l’intérieur du Spot entre sa partie centrale et la périphérie.

Tu disposes de 4 types de Spot:

- Normal : permet les retouches d’une zone de l’image (nuage, visage…)

- Excluding : permet d’annuler l’effet d’une partie des actions précédentes des 3 autres type de RT-spot

- Full-image : permet les retouches sur toute l’image en prenant en compte le deltaE

- Global : permet les retouche sur toute l’image, comme le mode “main” principal, sans deltaE, et pas de masques. Mais bien sûr on peut lui ajouter tous les modes précédents.

Il y a pour chaque outil, 3 niveaux de complexité:

- Basic : fonctions de base, pas de masque, pas de courbes (en général)

- Standard : plus de fonctions , masques simplifiés, courbes, graduated filter,…

- Advanced : toutes les fonctions (beaucoup), courbes, graduated filter, merge file (comme Photoshop en simplifié), etc.

Il y a plus d’outils que dans “main”… en général plus performants:

- Color & Light

- Shadows/highlight tone qualizer et “bientôt” GHS - Generalized Hyperbolic Stretch

- Log encoding

- Dynamic Range and Exposure

- Colour appearance (Cam16 & JzczHz) - Ciecam en simplifié avec “bientôt” en plus Sigmoid, etc.

- Common color mask

- Soft light / original Retinex

- Blur/grain and Denoise (wavelet, fourier, medians, Nlmeans,…)

- Tone mapping

- Dehaze and Retinex

- Sharpening (avec une grosse évolution en cours …)

- Local contrast & Wavelets

- Contrast by detail levels

Bon je ne suis pas là pour faire la promotion de RT, ce n’est pas le lieu - mais vue l’absence de documentation (serveur en rade ???)

Bonne journée

Jacques

Ok, ce n’est pas vraiment le lieu, mais c’est moi qui ai poussé à la roue. Après, ça serait peut-être bien d’ouvrir une rubrique. Je lance une bouée aux administrateur ?